如何用python进行中文分词

东西/原料

- python 3.8.2(其他版本也可以)

- pycharm 2020.01(其他版本也可以)

方式/步调

- 1

在本次教程中,我们采用pycharm进行编程。起首领会一下jieba库,jieba库是优异的中文分词第三方库。

jeiba库分词的道理:jieba分词依靠中文词库,操纵一个中文词库,确定中文字符之间的联系关系概率,中文字符间概率大的构成词组,形当作分词成果。

- 2

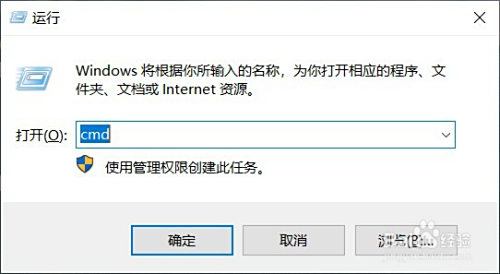

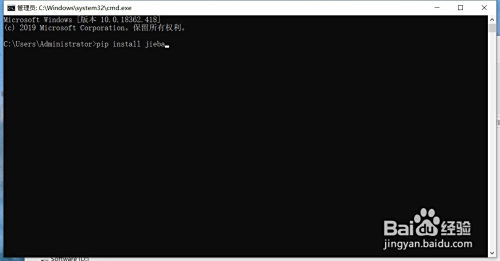

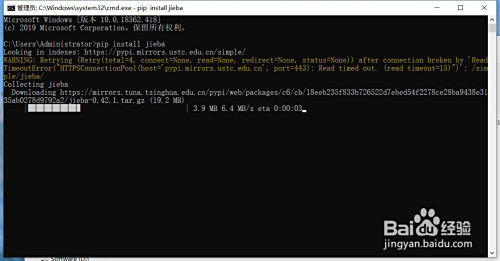

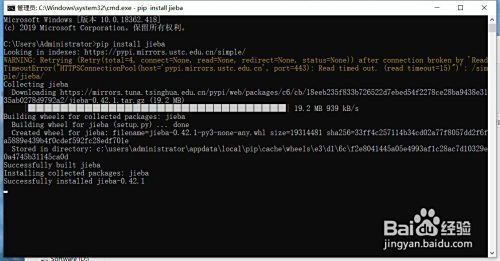

安装jieba库:

在桌面摁下“win”+“r”,输入cmd,接着输入“pip install jieba”,期待号令交运行完当作,当呈现“successful”就申明jieba库已经安装当作功了。

- 3

jieba库有三种分词模式,切确模式、全模式、搜刮引擎模式。

切确模式:把文本切确地且分隔,不存在冗余单词。

全模式:把文本中所有可能的词语都扫描出来,词与词之间存在反复部门,有冗余。

搜刮引擎模式:在切确模式根本上,对长词再次切分。

- 4

jieba库常用函数:

1、jieba.lcut(s) 切确模式,返回一个列表类型的分词成果

2、jieba.lcut(s, cut_all=True) 全模式,返回一个列表类型的分词成果,有冗余

3、jeiba.lcut_for_search(s) 搜刮引擎模式,返回一个列表类型的分词成果,存在冗余

(其他函数操作可以参照官方文档)

- 5

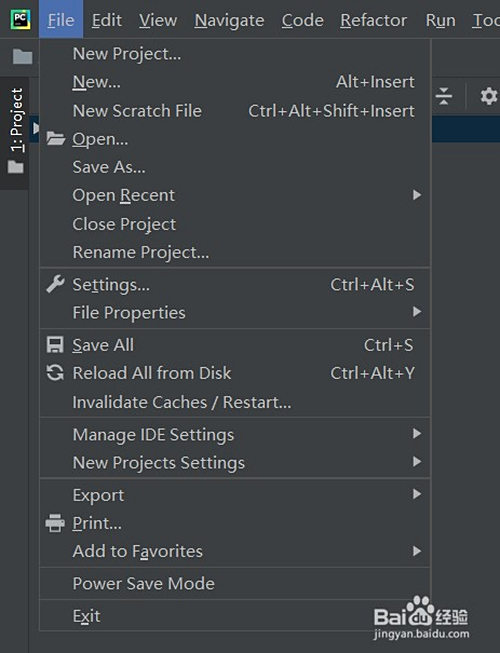

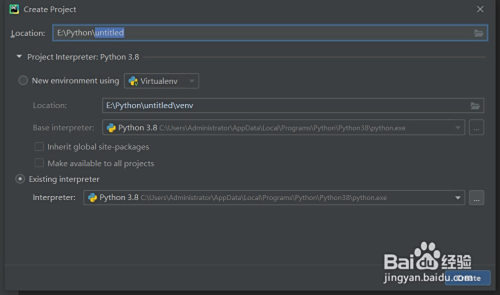

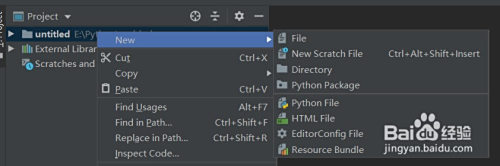

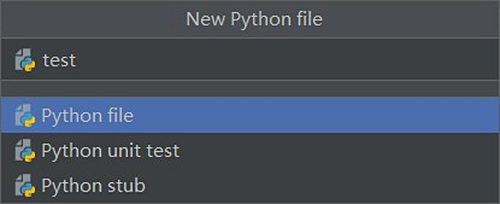

打开pycharm,点击左上角“File”-“New Project”新建一个项目(图1),选择肆意目次,选择python 3.8诠释器,点击“cerate”,在project处右键点击“New”-“Python File”,肆意取一个名字回车

- 6

在新建的py文件中输入:

import jieba

txt = "把文本切确地分隔,不存在冗余单词"

# 切确模式

words_lcut = jieba.lcut(txt)

print(words_lcut)

# 全模式

words_lcut_all = jieba.lcut(txt, cut_all=True)

print(words_lcut_all)

# 搜刮引擎模式

words_lcut_search = jieba.lcut_for_search(txt)

print(words_lcut_search)代码即可实现对字符串txt的分词

END

注重事项

- 文章利用pycharm进行编程,也可以利用IDLE进行编程。

- jieba库在安装时,若频仍呈现timeout,可以过段时候再试,或者运行 pip install jieba -i https://pypi.tuna.tsinghua.edu.cn/simple/ 利用清华源进行安装

- 官网文档请在pypi搜刮jieba

- 发表于 2020-04-24 19:00

- 阅读 ( 2409 )

- 分类:其他类型

你可能感兴趣的文章

- DNF维京硬币如何获取与兑换 1141 浏览

- 龙族幻想午夜频道攻略 1110 浏览

- 御剑修仙游戏如何添加好友 1105 浏览

- 明日之后,如何快速完成制作烤肉任务 1206 浏览

- 御剑修仙如何在地图里找到如歌 1220 浏览

- 最强大脑急转弯111 1216 浏览

- 剑与远征哭嚎荒漠通关攻略视频 1420 浏览

- 如何做前空翻(初学者) 2561 浏览

- 200斤胖子如何减身上的赘肉 1628 浏览

- 跑步的时候怎么改善自己呼吸节奏的技巧 1466 浏览

- 怎么在运动过程中保持持续的体力 1317 浏览

- 火车票正晚点怎么查询,智行火车票查询正晚点 2065 浏览

- 户外自行车骑行需要准备哪些装备 1521 浏览

- 智行火车票怎么查看足迹 6389 浏览

- 脑洞大师《逃离密室》11、12、13关怎么过攻略 1692 浏览

- 智行火车票12306抢票怎么添加收件地址 1570 浏览

- 抖音定格画面视频怎么弄 4067 浏览

- 智行火车票12306抢票怎么添加常用旅客 1993 浏览

- 脑洞大师《逃离密室》8/910关怎么过攻略 2161 浏览

- 苏州美食攻略之小吃篇 1542 浏览

- 单点解怎么变成固定解 5157 浏览

- 何为苏州园林,苏州园林包含哪些主要园林 1655 浏览

- 苏州博物馆之基本陈列篇 1917 浏览

- 江浙酒店攻略 1434 浏览

- 小鸡第一个月怎么养 1875 浏览

- java爬虫系列:怎么用jsoup进行爬虫开发?(3) 1441 浏览

- 百度文库知识店铺开通流程 2026 浏览

- iOS 13在哪里开启三维触控 2980 浏览

- 苹果手机怎么修改短信铃声 1740 浏览

- 教你使用数据可视化软件创建房产运营可视化大屏 1378 浏览

相关问题

0 条评论

0 篇文章

作家榜 »

-

xiaonan123

189 文章

xiaonan123

189 文章

-

汤依妹儿

97 文章

汤依妹儿

97 文章

-

luogf229

46 文章

luogf229

46 文章

-

jy02406749

45 文章

jy02406749

45 文章

-

小凡

34 文章

小凡

34 文章

-

Daisy萌

32 文章

Daisy萌

32 文章

-

我的QQ3117863681

24 文章

我的QQ3117863681

24 文章

-

华志健

23 文章

华志健

23 文章

推荐文章

- 脑洞大师《逃离密室》5/6/7关攻略

- 如何在车里舒服的睡觉

- 蓝车图片设计

- 彩凤蝶图片设计

- 城稻城亚丁自助游攻略

- 烛碗图片设计

- 怎么在支付宝中参与行走公益捐步

- 腹肌锻炼方法

- 杜鹃红山茶花注意事项

- 如何正确练习踢毽子

- 梦幻诛仙如何增强仙侣战斗力

- 2k20手机版徽章怎么解锁

- CSGO卡光效技巧

- 阴阳师怎么改绑定的身份证

- 孤岛惊魂5找出葛蕾丝阿姆斯壮的储藏室

- 明日之后,如何提升骁勇善战等级到3级

- 如何成为邮储食堂会员

- lol赛纳技能介绍

- 梦幻诛仙如何学习升级炼药

- 狂野飙车9特技怎么做

- 梦幻诛仙如何获取特殊外观的羽翼

- 无主之地3 主线 鹰身女妖之巢 任务攻略

- 欢乐斗地主残局第43关(困难难度)攻略

- 公主连结如何提升英雄等级

- 梦诛小镇如何生产麦芽糖

- 深海搁浅、strandeddeep、荒岛求生迷路了怎么办

- 香肠派对里面的近战武器怎么拿出来

- 修业点怎么卖给别人

- 公主连结如何新建小号

- 闪耀暖暖印象怎么获得